Riffusion是一个基于稳定扩散(Stable Diffusion)技术的实时音乐生成项目,由Seth Forsgren和Hayk Martiros在2022年开发。这个项目旨在探索人工智能在音乐创作领域的应用。Riffusion通过将音频信号转换为频谱图,然后利用稳定扩散模型生成新的频谱图,最后将频谱图转换回音频,从而实现音乐的实时生成。

Riffusion的核心技术包括:

音频-频谱图转换:将音频信号转换为时频域的频谱图表示。

稳定扩散模型:利用预训练的稳定扩散模型对频谱图进行生成和修改。

提示词插值:通过插值不同的文本提示词,实现音乐风格的平滑过渡。

图像条件控制:使用seed图像作为条件,控制生成音乐的整体结构。

频谱图-音频转换:将生成的频谱图转换回可听的音频信号。

Riffusion提供了以下主要功能:

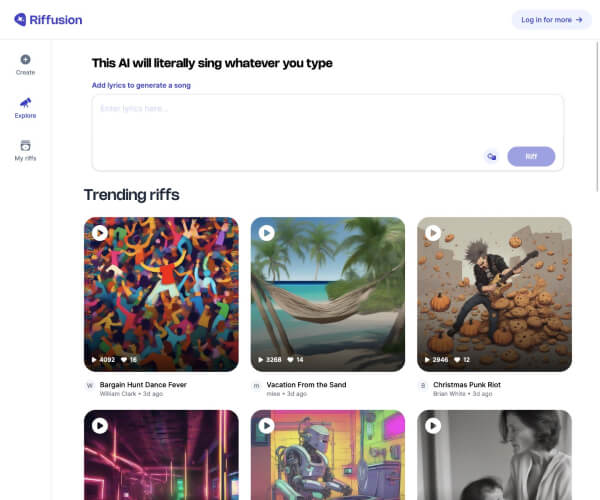

根据文本提示词生成音乐。

在不同音乐风格之间平滑过渡。

调整生成参数(如采样步数、去噪强度等)。

使用seed图像控制音乐结构。

实时音频预览和导出。

Riffusion最近获得了400万美元的种子轮融资,并计划使用这笔资金来增强应用的功能,包括创建和与他人共享音乐,同时也专注于开发能够生成更复杂、更精致的音乐作品的新AI模型。这个应用已被开源,并提供了免费使用的应用版本,允许用户描述歌词和音乐风格,生成可以公开分享或与朋友分享的音频片段。

Riffusion作为一个强大的灵感工具,允许用户根据文本描述快速生成音乐创意。对于音乐家来说,它可以作为创造力的跳板,为作曲提供独特的起点。非音乐家则可以在不需要传统音乐技能的情况下探索音乐创作。实时生成功能支持交互式实验,而调整和修改输出功能则允许个性化定制。此外,Riffusion使音乐制作民主化,让更广泛的受众能够接触到它,并可能彻底改变我们在数字时代对待音乐创作的方式。

注:以上内容均由智谱清言AI生成,仅供参考和借鉴!

©️版权声明:如涉及作品内容、版权和其它问题,请联系我方删除,我方将在收到通知后第一时间删除内容!本文只提供参考并不构成任何投资及应用建议。本站拥有对此声明的最终解释权。